삼성전자가 세계 최초 개발한 HBM-PIM. 삼성전자 제공

삼성전자가 세계 최초 개발한 HBM-PIM. 삼성전자 제공메모리 반도체 업계가 불황을 넘기 위해 감산에 돌입했지만, '선단(Advanced‧첨단) 제품'은 예외로 했다. 시장 잠재력과 수익성을 갖춘 선단 제품의 수요가 회복되면 빠르게 경쟁력을 확보하기 위해서다.

이 선단 제품 가운데 가장 주목받는 게 'HBM(고대역폭 메모리)' D램이다. 앞으로 수요가 폭발적으로 늘어날 것으로 전망되는 서버와 AI(인공지능) 부문의 최적화한 고성능 반도체이기 때문이다.

15일 업계에 따르면, 삼성전자는 지난달 말 '스노우볼트'라는 상표를 출원했다. 삼성전자가 하반기에 출시할 예정인 HBM3P의 브랜드가 될 전망이다. 앞서 삼성전자는 △아쿠아볼트(HBM2) △플래시볼트(HBM2E) △아이스볼트(HBM3) 등 시리즈별로 브랜드를 붙였다.

HBM은 SK하이닉스가 전 세계 최초로 개발한 고성능 메모리 반도체다. HBM은 여러 개의 D램을 수직으로 연결해 기존 D램보다 데이터 처리 속도를 대폭 끌어올렸다.

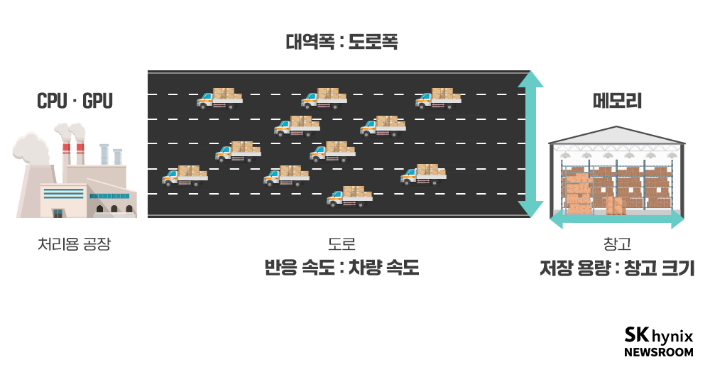

SK하이닉스 제공

SK하이닉스 제공메모리 반도체의 성능을 평가할 때 △대역폭 △반응 속도 △용량 등 3가지가 중요하다. 대역폭은 메모리에서 한 번에 빼낼 수 있는 데이터의 양을 뜻하고, 반응 속도는 CPU(중앙처리장치) 또는 GPU(그래픽처리장치)의 요청에 빠르게 반응하는 능력이다. 용량은 메모리 안에 담긴 데이터다.

대역폭은 도로폭, 반응 속도는 차량 속도, 용량은 창고의 크기로 비유할 수 있다. HBM은 도로를 4차선으로 확장하는 대신 1차선을 4층으로 쌓은 제품이다. 반도체 크기를 키우지 않고도 대역폭과 용량을 늘릴 수 있다. 최근 SK하이닉스는 세계 최초로 12단을 적층한 24GB HBM3 신제품을 개발했다.

삼성전자는 PIM(프로세싱 인 메모리) 기술을 개발해 세계 최초로 HBM과 접목했다. PIM은 연산 작업에 필요한 프로세서 기능이다. 이에 따라 HBM-PIM은 CPU와 메모리 반도체 간에 주고받는 데이터를 줄여 효율을 높였다. 즉 도로를 왔다 갔다 하는 차량의 수를 줄인 셈이다.

특히 오픈AI의 챗GPT로 촉발된 AI 시대에는 CPU보다 GPU가 더 주목받는다. 직렬 연산인 CPU보다 병렬 연산하는 GPU가 같은 시간 동안 더 많은 연산이 가능하기 때문이다.

HBM은 원래 고성능 그래픽 처리를 위해 탄생했다. AI에 사용하는 GPU는 한 번에 처리할 수 있는 연산량도 커진다. 따라서 대역폭과 용량이 크고, 면적당 집적도가 높은 HBM이 AI 시대에 필수 요소가 될 전망이다.

SK하이닉스가 세계 최초로 개발한 12단 적층 HBM3. SK하이닉스 제공

SK하이닉스가 세계 최초로 개발한 12단 적층 HBM3. SK하이닉스 제공HBM의 글로벌 시장 점유율은 △하이닉스 50% △삼성전자 40% △마이크론 10% 등 순이다. 전체 D램 시장에서 HBM의 비중은 1.5%에 불과하다.

하지만 AI에 대한 수요가 커질수록 HBM 시장의 성장도 폭발적으로 확대할 전망이다. 시장조사업체 가트너는 AI 반도체 시장이 2020년 230억 달러(약 30조 4450억 원) 규모에서 2025년 700억 달러(약 92조 6600억 원)까지 연평균 45% 이상 성장할 것으로 내다봤다.

유안타증권 백길현 연구원은 "HBM은 AI의 필수인 GPU 기반 서버 업체의 스펙 경쟁에 핵심"이라며 "하반기 이후 IT 수요 회복세가 기대되며 차세대 HBM 제품이 메모리 반도체 시장 내 높은 성장세를 보일 것"이라고 말했다.