| ▶ 글 싣는 순서 |

①"AI, 거짓말 왜 하죠?" 인공지능 일타 하정우 답은

②AI 안전연구소장이 딱 말한다…챗GPT 쓸 때 '이건' 주의

(계속) |

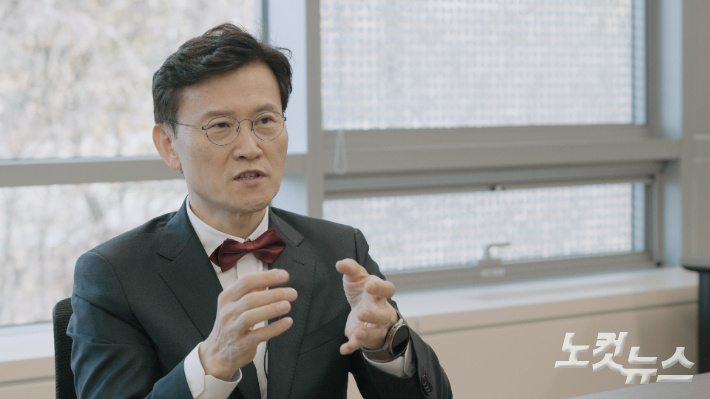

챗GPT로 대표되는 AI 혁명이 시작되면서 'AI는 안전한가'에 대한 의문들이 생겼다. 사람들은 그럴 때마다 '빨간 나비 넥타이'를 맨 교수님에게 물었다. 2001년 수도권 대학에서 처음으로 정보보호학과를 신설하고, 전문가들과 함께 인터넷윤리실천운동을 하다가 2018년 국내 최초로 '인공지능 윤리 가이드라인 Seoul PACT'를 만든 김명주 서울여대 정보보호학과 교수다. 현재는 국가 첫 AI 안전연구소(AISI)의 초대 소장을 맡게 됐다. 전 세계에서 6번째로 생긴 AI 안전연구소의 수장으로서, 이제는 우리나라의 AI 안전과 관련해 △평가, △정책 제안, △기술 개발 등의 일을 하게 됐다. 그에게 AI 안전연구소의 역할과 AI 안전에 대해 물어봤다.

국가 첫 AI 안전연구소의 역할

-AI 안전연구소 소장은 어떻게 맡게 되었나요? 지원을 한 건가요?

"지원을 했습니다. 공채로 뽑혔고요. AI 안전연구소가 사실 아무 것도 없는 상태에서 출발해야했기 때문에 정부 입장에선 기존의 연구소에서 인큐베이팅 시켜줄 수 있는 연구소를 찾았고요. 대전의 ETRI라고 전자통신연구원을 선정했습니다. 그래서 AI 안전연구소는 ETRI의 부속 연구소로 출발을 했고요. 연구소장도, 연구원들도 모두 공채로 뽑았습니다.

제가 30년 정도 교수를 하면서 IT 윤리와 규제, 보안 등에 헌신해왔는데 지금 AI 안전연구소에 다 녹아져 들어가 있거든요. 제가 평생 해왔던 것들을 마치 종합선물세트처럼 풀 수 있는 조직이라는 생각이 들어서 지원을 했습니다."

김명주 AI 안전연구소장-AI 안전연구소가 무슨 일을 하는 곳인가요? 아직 사람들은 AI 안전을 연구하는 곳인지, AI 관련 규제까지 할 수 있는 곳인지, 그것도 아니면 AI에 대한 가이드라인을 알려주는 곳인지 궁금해하거든요.

김명주 AI 안전연구소장-AI 안전연구소가 무슨 일을 하는 곳인가요? 아직 사람들은 AI 안전을 연구하는 곳인지, AI 관련 규제까지 할 수 있는 곳인지, 그것도 아니면 AI에 대한 가이드라인을 알려주는 곳인지 궁금해하거든요.

"말씀하신 게 다 들어갑니다. 예방적인 측면에서는 AI 제품이나 서비스를 개발하는 회사에게 이런 부분이 위험하다 이렇게 말할 수 있을 거에요. 예를 들면 AI 같은 경우 맨 처음 데이터를 모읍니다. 데이터를 학습하는데 데이터 안에 문제가 되는 게 많아요. 그래서 데이터 품질 관리를 어떻게 해야 된다부터 시작해서 이제 그 데이터를 실제로 현장에 배치해서 사용하는 데까지 나올 수 있는 문제들도 상당한데요. 보통 그걸 '잠재적 위험'이라고 하는데 그걸 발견하고 평가하고 제거하는 도구들이 있는데 그런 것들을 제공하기도 하고요.

또 사전 예방적으로 어떤 프로그램 등이 출시하기 전 문제가 없는 지 연구하고, 사후에도 문제가 있다는 것들이 지적되면 한 번 살펴보고 규제까지 하는 역할을 합니다.

전체 국민들이 다 고객이라고 볼 수 있습니다. AI 시대가 되면서 이거 우리 써도 될까? 우리 아이들에게 줘도 되나? 이거 문제가 있는 거 아니야? 이걸 누구랑 이야기 해야하나 봤을 때 저희가 AI 안전에 관한 일종의 포털처럼 정보도 주고 이용자 가이드라인도 제공하는 역할을 하는 거죠."

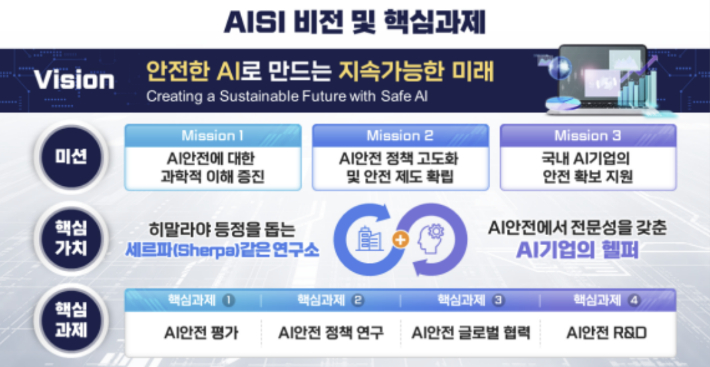

AI안전연구소 인포그래픽. 과기정통부 제공-전체 국민들이 다 해당 된다고 하니까 생각이 나는데, 딥페이크 같은 것도 다루는 것이죠?

AI안전연구소 인포그래픽. 과기정통부 제공-전체 국민들이 다 해당 된다고 하니까 생각이 나는데, 딥페이크 같은 것도 다루는 것이죠?

"네 AI 안전연구소에서 제일 먼저 다루는 게 위험입니다. ①기술적 위험 ②사회적 위험 (고용 노동 등) ③정치적/국가적 위험 (가짜뉴스 등) ④환경적 위험(AI 에너지 과다 사용 등) 모든 분야의 위험을 다 다루기 때문에 AI 안전연구소는 어떻게 보면 '기술' 연구소라기 보다는 '정책' 연구소가 맞습니다. 그래서 정책에 필요한 기술도 개발하는 거고 이제 국가에 필요한 정책 같은 것도 제시하는 거죠."

-그럼 조직 구성이 어떻게 되고 현재는 몇 명 정도 인가요?

"연구소 산하 연구실이 3개 있습니다. ①정책을 담당하는 팀, ②AI가 위험한지 여부에 대한 평가를 하는 팀, ③AI 기술 연구를 하는 팀이 있습니다. 기술 연구하는 파트에선 딥페이크를 방지하거나 찾아내고 딥페이크인지 판단하는 기술을 만들어낼 수도 있고요. 민간기업들에서도 이 연구를 활발히 하고 있는데요. 저희는 국가기관이기 때문에 개인 기업들이 하고 있는 것과 충돌하면 안되니까, 민간 기업이 주력하지 못한 부분을 연구하거나, 민간 기업과 함께 협력하는 방안을 생각하고 있습니다.

출범 현재는 ETRI 파견인력과 TTA(정보통신기술협회) 파견인력 등 13명입니다. 내년 1월 신규 6명을 우선 채용하고, 내년까지 전체 직원을 30명 규모로 늘릴 예정입니다. 영국이 AI 안전연구소를 세계에서 가장 먼저 만들었는데, 영국은 직원들이 공무원일 뿐 아니라 풀타임 인력도 130명에 달합니다."

챗GPT 사용할 때 주의할 점

-이제 정말 많은 사람들이 챗GPT를 많이 사용 하잖아요. 사용할 때 주의할 점을 알려주세요.

"사실 챗GPT가 처음 나왔을 때는 내 대화 내용을 학습에 활용하는 것 아니냐는 문제들이 많이 나왔습니다. 이탈리아에서 3주간 챗GPT 금지를 내렸던 이유도 대화하면서 국민들의 사생활 정보를 가져다가 재학습하는 것 아니냐 조치를 취하라 했던 거고요. 그때부터 대화했던 내용을 삭제하고 대화를 학습에 활용하지 않겠다고 한 것이고요. 현재 오픈 AI는 대화 내용을 학습에 사용하지 않고 기본적으로 사용자의 개인 요청을 처리할 때만 사용한다고 합니다.

오픈 AI가 명시적으로 학습에 활용하지 않는다고 했어도 챗GPT와 대화할 때 남들에게 노출되면 안되는 정보들은 가급적 올리면 안됩니다. 주로 사생활 정보를 올리지 말고 업무와 관련된 것들만 많이 써라 이렇게 추천하죠. 다른 사람들의 이름과 주소, 휴대전화 번호 등 유출되거나 학습이 되면 안 되는 것들은 넣지 말아야 합니다."

-최근에 화제가 됐던 것 중 하나 챗GPT 한테 "나도 모르는 나를 알려줘"라고 물어보는 것이었는데요. 저도 한 번 해봤는데, 제 아이의 이름과 나이, 직업, 제 관심사를 너무나 정확하게 알려주더라고요.

"챗GPT와 대화하고 그대로 내버려 두지 말고 삭제하는 것도 좋습니다. 챗GPT의 설정 →개인 맞춤 설정에 들어가서 '메모리'를 끌 수 있습니다. 어떤 분들은 챗GPT와 대화하고 필요한 질의 응답만 따로 USB 같은 곳에 저장을 하고 대화 내용을 바로바로 삭제하는 분도 있는데 이것도 좋은 방법입니다."

-챗GPT를 보편화되면서 아이들도 검색 포털처럼 사용하려고도 하는데, 학부모로서 어떻게 가이드라인을 줘야할지도 고민입니다.

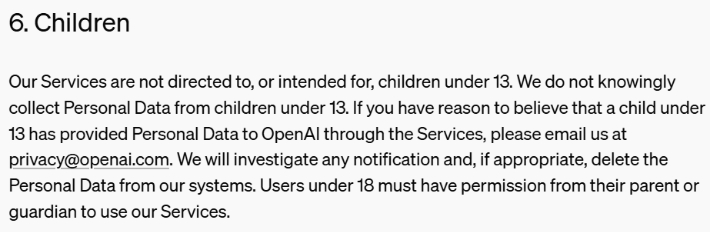

"챗GPT가 '연령 제한'이 있는 걸 아셨나요? 회원 가입할 때 약관 동의 등에 연령 제한 표시가 있습니다. 13세 미만의 아동들에게는 사용을 권하지 않지요. 꼭 필요하다면 부모님의 지도 아래서만 사용하는 걸 추천합니다."

실제로 오픈 AI의 '개인정보 처리 방침(24년 11월 4일 기준)'에 따르면, 오픈AI의 서비스 대상은 13세 이상이다. 또 만 18세 미만의 이용자는 부모 또는 보호자의 허가를 받아야만 오픈AI의 서비스를 이용할 수 있다고 적시했다.

오픈 AI의 '개인정보 처리 방침(24년 11월 4일 기준)' 캡처

오픈 AI의 '개인정보 처리 방침(24년 11월 4일 기준)' 캡처해외의 AI 안전연구소는 지금

-AI 안전연구소는 국제 네트워크를 위한 역할도 한다고 했습니다. 개소식 전 주에 해외도 다녀오셨고요. 다른 나라는 지금 AI 안전연구소를 어떻게 운영하고 있나요?

"최초의 AI 안전연구소는 영국이 만들었습니다. 그게 작년 11월로, 1년 정도 됐습니다. 그때 런던 AI 정상회담을 열면서 AI 안전연구소를 만들었고요. 현재는 130명 인원을 갖췄고, 세계에서 가장 큽니다. 사실 AI 주도권 싸움에서 영국이 유리한 위치를 차지하려고 만든 건데요. 왜냐햐면 대부분의 AI는 미국기업이니까 미국을 견제할 목적으로 시작한 거죠. 그런데 미국에서 바로 똑같은 이름의 연구소를 세웠어요. 그리고 싱가포르, 일본, 캐나다 우리나라가 6번째로 연구소를 세운거고 연구소 이름이 다 똑같습니다. AISI.

올해 샌프란시스코에서 처음으로 안전연구소 소장들이 모인 협의회를 연 겁니다. 이 때 3가지 트랙으로 논의를 했는데 ①일반적인 AI를 어떻게 평가할 거냐, ②AI가 가지고 있는 위험은 어떻게 평가할 거냐 ③딥페이크를 어떻게 볼 것이냐 3가지 트랙이 운영됐습니다."

-영국은 저희보다 1년 정도 먼저 운영을 한 건데 소장님이 말씀하셨던 정의와 도구 개발이 어느 정도 마련돼 있는 걸까요?

"요슈아 벤지오라고 보통 AI 3대 천왕이라고 하는 분이 그곳의 책임자가 되어 AI 위험 보고서를 1년 전에 한 번 냈고요. 그 업그레이드 버전을 지금 준비하고 있더라고요. 위험과 안전에 관한 최고의 레퍼런스를 만드는 작업을 지금 하고 있고요. 위험을 평가하는 도구들은 몇 개 만들어서 실험을 하고 있더라고요.

AI에 관한 사이버 보안을 위한 별도의 팀을 또 만들더라고요. 저희는 안전 속에 보안을 넣을 생각을 하고 있는데 영국은 보안 쪽이 너무 크고 국가 안보와 연관이 있기 때문에 별도 팀을 만드는 것을 보고 있는데 이런 걸 보면서 접근하는 방법도 많이 배워야 할 것으로 보고 있습니다."

AI안전연구소 인포그래픽. 과기정통부 제공-AI 안전연구소 초대 소장으로서 당면 과제는 무엇일까요?

AI안전연구소 인포그래픽. 과기정통부 제공-AI 안전연구소 초대 소장으로서 당면 과제는 무엇일까요?

"어떤 문제를 풀려고 할 때 맨 처음 시작해야 할 게 문제에 대한 정의입니다. 정확한 정의. 그게 바로, 안전연구소에서는 도대체 AI 안에 어떤 위험이 있는가를 파악하는 겁니다. '잠재적 위험'이라는 표현을 하는데요. 그 잠재적 위험을 최대한 영역별로 정치, 경제, 사회, 교육, 문화 이런 쪽을 다 풀어서 기술까지 문제 정의를 정확히하고요. 또 우리나라만 풀어야 하는 건 아니기 때문에 다른 나라의 AISI와 같이 규합해서 풀고 그런 위험이 제품 안에 얼마나 있는지 측정을 해야 하잖아요. 그런 도구를 개발하는 게 우선이라고 생각합니다.

그 다음에 이미 이미 알려진 많은 문제들, 이를테면 딥페이크, AI 해킹 공격 등에 대해 기술적 개발 조치도 같이 병행할 생각입니다."

-딥페이크는 우리 뿐 아니라 세계적 문제로 보여집니다.

"전 세계적으로 핫이슈입니다. 이탈리아 총리가 여성 분인데 이 분도 총리가 되기 전 딥페이크 사건에 한 번 휘말린 적이 있었고 범죄자를 잡았다고 합니다. 총리가 되고 나서도 1억 5천만원 정도의 민사 소송을 걸었고요. 성범죄자의 피해자들이 오히려 주눅들어 사는데 일부러 그렇게 되지 말자고 총리가 되자마자 민사 소송을 걸어서 돈을 내놔라 하기도 했다고 하더라고요.

전세계에 딥페이크 포르노 사이트가 지금 400여개 이상이 되는데, 영국의 한 방송사가 조사를 했더니 등장 인물이 나오는 가장 많이 나오는 국가가 한국이었다고 합니다. 케이팝(K-pop)이 유행을 하면서 케이팝 스타가 타겟이 된 거죠. 본인도 모르는 사이에 이렇게 되는 건데요. 기획사에서 엄정하게 대응하겠다고 했지만 대응 하려고 하면 끝도 없이 대응을 해야 하는 상황입니다."

-그럼 AI 안전연구소에서 딥페이크 피해를 도와주는 역할도 하는 건가요?

"원래 우리나라 규제 기관들이 있잖아요? 방송통신위원회, 여성가족부 등이 있고 경찰·검찰도 있고요. 저희는 수사기관은 아니지만 기술적으로나 정책적으로 정책이나 법을 이렇게 좀 바꿔주면 좋겠다, 이런 것들을 제시하고 어떤 기술이 필요하다고 하면 기술을 개발해서 보급하는 그런 역할을 하게 될 겁니다."